В начале сентября 2021 года CEO Xperience AI Анна Петровичева побывала в гостях у подкаста «Крит Мышь». Публикуем текстовую версию разговора (послушать сам подкаст можно по ссылкам ниже).

Александр Головин: Привет, это КритМышь – подкаст для тех, кто мыслит критически. Меня зовут Александр Головин. Сегодня со мной по видеосвязи находится специалист по нейросетям, CEO компании Xperience.AI Анна Петровичева. Привет!

Анна Петровичева: Всем привет!

А.Г: Мы с Анной сегодня поговорим про компьютерное зрение. Обсудим, что это за технология, какие прекрасные, – а может пугающие – перспективы она для нас готовит. Анна, давай начинать. Хочется для начала тебя спросить – на каком этапе развития этой технологии мы находимся? Что компьютерное зрение уже может, а что до сих пор находится в области научной фантастики?

А.П: Компьютерное зрение занимается задачами, которые легко решаются человеком – например, посмотреть на картинку и посчитать количество людей на ней. Если на задачу требуется какое-то большее время, например, понять, как в 3D будет выглядеть чертеж здания, которое я вижу, – такого оно пока не умеет.

Зачем нужна капча и может ли нейросеть быть расистской?

А.Г: Я все еще натыкаюсь на разного рода защиту: например, капчу на разных сайтах, когда нужно отметить мотоцикл или пожарный гидрант на фотографии. Это некоторая защита от проникновения ботов. Обойти это – все еще сложная задача для компьютерного зрения?

А.П: Уже есть нейросети, которые делают это хорошо. Большой секрет (или уже не секрет) заключается в том, что таким образом Google размечает себе датасеты. Раньше эта капча часто была двухстадийной. Первую стадию было просто пройти, а вторая была странной. Там были такие же задачи, типа «найдите пожарный гидрант», но его видно хуже. Эта вторая часть – она использовалась не для верификации, а для того, чтобы разметить датасет, на котором еще лучше можно натренировать нейронную сеть для распознавания пожарных гидрантов – у Google такая сеть есть. У других ребят, наверное, нет, но мы находимся близко к тому, чтобы распознавать такие штуки было просто.

А.Г: Помимо того, чтобы находить на картинках пожарные гидранты, зачем вообще эта технология нужна? Каковы основные направления ее применения? Области, в которых это наиболее бурно развивается?

А.П: Этих областей достаточно много, но при этом алгоритмы одни и те же. Мне очень нравится говорить про медицину, поэтому я для начала расскажу про нее. Сейчас глубокое обучение и компьютерное зрение активно приходит в диагностику болезней. Оно помогает радиологам, которые смотрят на результаты МРТ, найти подозрительные области, опухоли. Есть исследования, которые говорят, что сейчас нейронные сети с этим справляются примерно так же хорошо, как радиологи, но хуже, чем коллегия докторов. Коллегия докторов пока что справляется лучше. Кажется, скоро мы и до такого уровня качества дотянемся. Один из основоположников области нейронных сетей, Джоффри Хинтон несколько лет назад сказал: «Если вы сейчас учитесь на радиолога, лучше учитесь на кого-то другого, потому что скоро ваша профессия будет заменена». Это, наверное, сильное утверждение – пока что радиологи все еще существуют. По многим причинам, включая законодательные. Но глубокое обучение там уже хорошо используется.

Еще одна индустрия, в которой очень важно глубокое обучение – это безопасность. Видеокамеры, которые стоят по периметру серьезных объектов – сейчас в них часто есть технология распознавания того, что происходит вокруг. Не нужно сажать человека, который будет 24 часа в сутки в эту камеру смотреть и распознавать глазами эти объекты. Кроме этого, глубокое обучение приходит и во всякие развлекательные сферы, например, в спорт. Может быть, помните, в прошлом году была такая новость, что умная камера вместо того, чтобы следить за мячом на футбольном матче, следила за лысой головой рефери. Но в целом технология такая – умная камера сама вращается и следит за мячом. Такие же технологии работают для других видов спорта – для тенниса, для плавания. Они помогают с двух сторон: с одной стороны, это автоматические трансляции, с другой – это помощь в тренировках.

А.Г: При этом ты сказала, что алгоритмы одни и те же. Можешь описать их понятными терминами? Что это за алгоритм такой, что он один и тот же, а области такие разные?

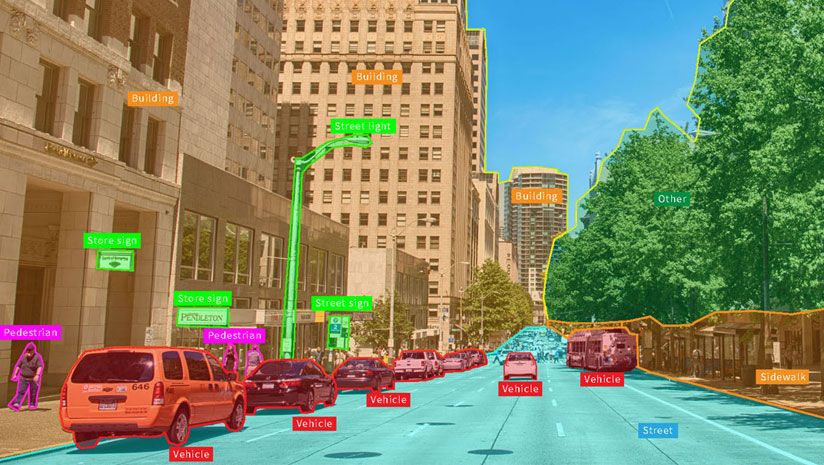

А.П: Я расскажу, как они строятся. Критически важная штука для того, чтобы построить хороший алгоритм – это данные. Нейронные сети и компьютерное зрения – это очень «жадная» область для данных. Нужны тысячи, даже десятки и сотни тысяч изображений. Некоторые датасеты насчитывают миллион картинок. Например, если мы хотим натренировать алгоритм, который будет следить за мячом в футбольном матче. Нам нужно собрать максимально разнообразные изображения с футбольными матчами, снятыми на вот эти камеры с трансляций. С разными футболистами, в разное время суток, в разную погоду – солнце, дождь, снег, все возможные ситуации. Далее мы просим человеческого аннотатора, – разметчика, – разметить мяч на каждой из этих фотографий. То есть, он обводит его квадратиком на каждой фотографии и результатом этого является размеченный датасет. Это ключевая штука для того, чтобы сделать алгоритм. В зависимости от области этот датасет будет разным, то есть он может быть про МРТ или про футбол, или про безопасность, но в любом случае – это набор картинок или видео, в которых человек что-то отметил. А дальше мы берем нейронную сеть и начинаем ее тренировать.

Мы берем, например, изображение футбольного поля без разметки, показываем его нейронной сети и просим найти мяч. Она нам выдает этот мяч в некоей форме, – ну давайте представим, что это координаты прямоугольника. Мы ей говорим – ты не права, на самом деле координаты были вот такие. Потом мы вычисляем разницу между тем, что она нам предсказала, и тем, что должно было быть, подстраиваем ее параметры так, чтобы в следующий раз она не ошиблась. Мы делаем много тысяч, десятков тысяч, миллионов проходов по изображениям. Мы случайным образом берем изображение или набор изображений из датасета, просим предсказать, говорим «нет, не так» и подстраиваем. Такой процесс обучения обычно занимает часы или дни. Сейчас все больше становится рекордов, чтобы это делалось за минуты. Но пока что стандарт – это все еще часы или дни. В результате получается алгоритм, который умеет предсказывать на тех изображениях, которые он еще не видел.

А.Г: Мне здесь очень любопытна роль человеческого аннотатора. Мне она кажется ключевой. Часто, когда люди со стороны разговаривают про компьютерное зрение, может возникнуть ощущение, что нейросети супер объективны, лишены нашей человеческой субъективности. Можешь как-то прокомментировать? Насколько компьютерные системы отражают действительность такой, какая она есть? Или они biased?

А.П: Они точно biased, 100%. Обычно мы берем разметку, которая была сделана человеческими аннотаторами. С ними можно поговорить и указать, что мы не делаем такую дискриминацию или мы стараемся не применять расизм в подборе датасета. Но часто датасеты собираются немного по-другому. Вместо того чтобы размечать датасет с какой-то командой, бывает возможность собрать датасет автоматически из того, что уже есть в интернете. В этом случае в датасете представлены все те самые biases, которые есть в людях в интернете. Хороший пример на эту тему – приложение FaceApp, которое умеет менять возраст, пол по лицу. Я загружаю свою фотографию и могу посмотреть, как я буду выглядеть через 50 лет или как я выглядела ребенком, очень прикольно. Что важно – там есть такой фильтр, который говорит «сейчас я сделаю тебя очень красивым». Этот фильтр отбеливал людей, у которых темная кожа. Там скорее всего «красивые люди» были в основном белыми людьми. И сеть научилась тому что красивый человек = белый человек. Они это дело потом починили через сбор датасета более репрезентативным способом, но тем не менее.

А.Г: Важно подчеркнуть – в интернете воспроизводятся наши социальные установки, в том числе предубеждения и стереотипы. И люди, которые мало репрезентированы в сети, могут оказаться невидимыми для алгоритмов, просто потому, что нет данных, на которые можно опереться.

А.П: Да, сто процентов.

А.Г: И это, конечно, проблема, потому что мы берем технологии и несем в реальный мир, где эти люди все-таки существуют. Возникают разного рода казусы, далеко не все безобидные, как тот пример, который ты привела, где лицо отбеливается.

А.П: Да, есть, на самом деле, более жесткие. Есть алгоритмы распознавания лиц, которые значительно хуже работают на людей с темной кожей.

Технология распознавания лиц: как это делают в Китае и на Западе

А.Г: Здорово, что ты упомянула это, потому что я хочу поговорить о технологии распознавания лиц. За этим чрезвычайно интересно наблюдать из-за некоторых очень странных и очень пугающих применений этой технологии. Говоря про невидимость некоторых людей – насколько я успел понять, у технологии распознавания лиц большая проблема с темнокожими женщинами. По крайней мере, в материалах, которые мне попадались, частенько указывалось, что они хорошо умеют определять белых мужчин, мужчин темнокожих, а вот с темнокожими женщинами какая-то беда.

А.П: Слушай, нельзя сказать, что есть какой-то один алгоритм и у него вот такая проблема, потому что, на самом деле, этих алгоритмов много и они построены на разных датасетах. Например, в 19-м году, еще до пандемии, я успела слетать в Китай и поговорить там с товарищами, которые делают алгоритмы распознавания лиц. Я к этому отношусь двояко. С одной стороны, это действительно классная наука и они продвигают технологию. С другой стороны, основной пользователь этих алгоритмов распознавания лиц – китайское государство, то есть, они делают это на государственном датасете. Меня поразило, что есть государственный датасет китайцев и они на нем тренируют нейронную сеть. При этом есть некая государственная штука, которая может померить качество натренированной сети на своем приватном датасете и посчитать. Числа, за которые они борются – это второй знак после запятой. То есть, там качество сейчас 99,96%, а хочется 99,97%. Компании сильно борются за 97 сотых, потому что это означает много миллионов долларов, ведь тогда именно у них китайское государство закупит эту систему, чтобы распознавать китайцев на камерах, которые установлены на перекрестках.

А.Г: Ты имеешь в виду точность распознавания?

А.П: Да.

А.Г: Чтобы закрепить в сознании слушателей. Есть алгоритмы распознавания лиц, которые делают это с 99% точностью, с сотыми долями после запятой точностью.

А.П: Да. Причем они, на самом деле, очень недовольны текущим качеством, потому что в масштабах Китая одна сотая процента – это десятки тысяч человек, которых перепутали между собой. А в Китае, чтобы понимать, большая часть оплат сейчас происходит по лицу. Например, ты приходишь в будку с мороженым. Штука, в которой работает нейросеть, фотографирует меня, понимает, что меня зовут Аня и надо списать именно с моего счета деньги за мороженое. Поэтому это реальная проблема: деньги могут списать не с того человека, и они из-за этого сильно переживают.

А.Г: Вот эта точность – она для каких фотографий: для снимков в профиль, смотря в камеру, чтобы лицо ничего не закрывало? Или это для ситуаций, когда я закутан в три платка, у меня видно только глаза и переносицу и даже в таком случае она меня может опознать?

А.П: Слушай, ни то и ни другое. Это для ситуаций, когда ты спокойно идешь по улице или подошел к будке с мороженым. Не нужно специальным образом хмуриться и смотреть в камеру, она все поймет без тебя. Но должно быть видно лицо. Как эта штука работает сейчас с масками – я, честно говоря, не знаю.

А.Г: То, что эта технология так популярна у китайского государства, вполне объяснимо. Я пока готовился к разговору, посмотрел видео, как журналистки и журналисты ходят по Китаю и удивляются тому, как эта технология применяется. Я видел в сюжете, как журналистка показывает, как устроена выдача туалетной бумаги в общественном туалете.

А.П: О да.

А.Г: Да, это правда? То есть, ты подходишь к туалету и она тебе «вот тебе кусочек бумаги, дорогое лицо»?

А.П: Все так.

А.Г: И если тебе надо больше по каким-то причинам, она говорит «подождите 10 минут, вы уже получали».

А.П: Все правильно. Культура пользования туалетом у китайцев вообще сильно отличается от того, что я видела в любой другой стране.

А.Г: Любопытное применение технологии. Неужели такой дефицит с туалетной бумагой, если нужен такой диспенсер?

А.П: Если честно, я не знаю, стоит ли нам погружаться в туалетную тему, но вообще туалеты в Китае делятся на две категории – те, в которых вот так, и те, в которых ты должен платить за бумагу. Поэтому эти лучше.

А.Г: Отсюда из России смотрится довольно диковато. Другой сюжет, который мне запомнился – это технология распознавания лиц в роли консьержа на входе в любое помещение, любой дом. Камера по лицу регистрирует входящего, открывает перед ним дверь, если он здесь живет или как-то зарегистрирован. В систему также попадает, кто приходит к нему в гости, в каком количестве и потом это все можно отследить.

А.П: Все так, да. Это не то, чтобы в каждом доме или офисе, но почти везде. Я так понимаю, что они еще достаточно быстро прикрутили к этому систему измерения температуры, поэтому можно еще и посмотреть, не болеет ли этот человек прямо сейчас.

А.Г: Это любопытно. Настолько, что журналистка спрашивает такого консьержа, который управляет этой системой в одном из домов – скажите, вы собираете данные, про которые не можете мне сказать, правда? И он говорит «ну да, вы же понимаете, что я не могу все сообщить». Получается, там есть какая-то еще потайная сторона сбора, про которую не всем известно.

А.П: Сто процентов. Сейчас в сообществе исследователей нейронных сетей растет все большее недовольство на тему распознавания лиц, пола, возраста, этнической принадлежности людей по фотографиям или видео. Поэтому многие библиотеки, в которых раньше были стандартные алгоритмы для этого, поудаляли их в последние несколько месяцев из этических соображений. Нехорошо просто так собирать данные о том, как люди живут, общаются и вообще.

А.Г: Но это не про Китай.

А.П: Нет.

А.Г: Давай попробуем обсудить, как с этим во всем остальном цивилизованном мире, в западных странах, например. Насколько я успел понять, в Штатах нет федерального законодательства на тему алгоритмов, но есть разные региональные решения, в том числе о том, что в некоторых городах запрещены такие сборы данных. Как в других странах к этому относятся?

А.П: Все больше запрещают. Обычно запрещают, не вообще детектировать лица у людей и распознавать их, а, например, запрещают полицейским этим пользоваться. Я слабо себе представляю, как можно действительно реализовать этот закон, проверить, что каждая умная камера делает внутри себя и не распознает ли она случайно лицо. Это может привести к тому, что не будет какой-то единой базы, которая идентифицирует мое лицо и мое имя, потому что это нужно делать на масштабе страны, а не на масштабе региона или города. Но в масштабах магазина, например, распознать меня, как постоянного покупателя, я не думаю, что что-то может запретить провайдеру такой технологии.

А.Г: Запреты не на ровном месте появляются. У людей есть точно обеспокоенность по поводу такой технологии и не напрасно. Хочется поговорить про то, что вызывает такое беспокойство. На примере Китая довольно хорошо видно – я бы не хотел, чтобы мне туалетную бумагу выдавали по лицу. И только определенное количество. Получается, что когда ты выходишь на улицу и попадаешь в поле зрения любой камеры, ты мгновенно становишься объектом взаимодействия с этой системой, хочешь ты того или нет. При том та точность, с которой эти алгоритмы способны лица распознавать, подсказывает, что спрятаться невозможно, учитывая проникновение практически на каждый угол каждого дома камер наружного наблюдения. Такое чувство, что присказка про большого брата совсем рядом. Как ты сама к этому относишься? Не пугает?

А.П: Я чувствую обеспокоенность тем, что есть классная, крутая технология, которая, возможно, попадет не в те руки и будет использована не так. Мы в команде приняли решение, что мы не будем разрабатывать ничего, что связано с любыми военными или государственными применениями этой технологии. Не хочется сделать что-то такое, о чем я буду жалеть через условные пять лет. Но государство и военные, на самом деле, очень интересуются этой технологией, и игнорировать это нельзя. Если честно, я не думаю, что можно целиком и полностью на текущем этапе это отменить или запретить. Но точно нужен открытый диалог между людьми, которые понимают, как это работает изнутри, и людьми, которые хотят ее применять для разных целей.

Мы в команде приняли решение, что мы не будем разрабатывать ничего, что связано с любыми военными или государственными применениями этой технологии. Не хочется сделать что-то такое, о чем я буду жалеть через условные пять лет. ч

А.Г: Мы, в том числе, для этого собрались. Хочется поговорить про последствия. Кто-то может подумать – ну а что плохого? Ну будет у полицейских возможность распознать преступника по лицу. Разве это плохо? Чем это может быть плохо? Идет человек в толпе, а система его распознает и помечает как человека, совершившего преступление какое-то время назад. Тут же приехали полицейские, упаковали его и все. Что в этом плохого?

А.П: Здесь может быть применена ровно та логика, которая работает для cookies. Человека явно предупреждают, что с него собирают cookies, и он может отказаться. Только здесь ты не можешь отказаться, вот висит эта камера и ты от нее не можешь скрыться. Я думаю, что здесь проблема в отсутствии выбора. Готов ли человек, чтобы его снимала камера или не готов. Для cookies такой выбор уже есть, он не целиком защищает человека от рекламных трекеров, но уже достаточно сильно. Если посмотреть в эту индустрию, трекинг пользователей интернета для того, чтобы им таргетированную рекламу показывать. Люди достаточно обеспокоены этой проблемой, компании пытаются найти способы, которые бы защищали человека от слежки. В последнем релизе компании Apple они сильно запретили трекинг за своими пользователями в Safari, например. В индустрии, связанной с искусственным интеллектом, такого пока не происходит, возможно потому, что она сильно моложе.

А.Г: Что меня лично беспокоит в применении такой технологии. Дело же не в том, что тебя распознает камера на входе в магазин и говорит «привет, Александр» или «привет, Анна, добро пожаловать обратно в наш магазин, вот вам скидка 20% на ваши любимые товары». Это довольно безобидно, было бы здорово, если бы мой магазин, в который я постоянно захожу, меня узнавал, почему бы и нет. Другое дело – это же всепроникающая система, камеры есть абсолютно везде. Если все это объединяется в единую систему наблюдения, то возникает очень нехороший соблазн восстанавливать весь его путь. Не просто за сегодня, а за все время наблюдений, можно же посмотреть, хчем человек занимался месяц назад, куда он ходил, что он делал, с кем общался. И тут возникает странный эффект – все перестает быть приватным.

А.П: Я согласна. Быть все время под наблюдением чего-то такого, что непонятно, в чьих руках находится – это неприятная мысль.

А.Г: Хуже того – тебя нужно как-то опознать, а значит нужно собрать данные и обучить. Значит, все фотки, которые я выкладывал в интернет, Facebook или ВК, кто-то их собрал, проанализировал, загрузил в датасет и теперь использует, чтобы меня идентифицировать. То есть там, в этой базе, могут быть фотографии меня, которых я вообще никогда не видел. Они сделаны другими людьми, а я просто попал в кадр. Например, я хожу по Питеру, кто-то фоткается, я попал случайно на камеру, кто-то это выложил в интернет и алгоритм считал мое лицо и все, я в базе.

А.П: Уже была такая история, Facebook показывал твоим друзьям какие-то другие фотографии, на которых есть ты, и говорит «Это правда, что это ты?». Ты даже можешь не знать, что такие фотографии были сделаны. Зачем их показывать твоим друзьям, это вообще какая-то странная история.

Будущее с технологией компьютерного зрения: пессимизм против оптимизма

А.Г: Такое чувство, что пройдет еще пара лет, ну с десяток в лучшем случае, и мы окажемся в мире, где эти алгоритмы будут настолько всепроникающими, что они будут везде. Даже если их запретят в отдельной стране, хотя вряд ли это произойдет в России. Мы так или иначе будем объектами взаимодействия с этой системой. Но вот ты сказала – а вдруг технология попадет не в те руки? Я когда слышу «те руки», я хочу спросить – что это за руки такие и как можно понять, те они или не те? По-моему, когда технология становится настолько мощной и настолько всепроникающей, уже не может быть тех или не тех рук. Все руки такие себе. Сила технологии и соблазн настолько велики, что это неизбежно. Просто хочется понять – что это за мир будет?

Например, я иду по улице и биллборды вместо того, чтобы показывать общую рекламу, будут показывать рекламу лично мне. Они знают, куда я иду, где я был только что, с кем я только что разговаривал. Можно сюда нафантазировать реалистичную интеграцию с социальными сетями, другими системами, которые у нас есть. Что это объединится в такую всепроникающую, всесуществующую, всевидящую систему наблюдений и взаимодействий. Любое приватное действие становится заведомо невозможно и хуже того, как ты и сказала, отказаться от этого нельзя. Если сейчас я могу удалить страницу в социальных сетях или не заводить ее изначально, то скрыть лицо невозможно. Даже если ты скрываешь лицо, ты автоматически виден как человек, скрывающий лицо, это не становится менее подозрительно.

А.П: Я более позитивно смотрю на будущее. Я сказала, что полностью такие алгоритмы не запретишь, внутри какого-то одного бизнеса их все еще можно будет применять. Но какую-то систему, которая будет работать одновременно, нельзя будет сделать. Потому что тот же самый Google, Apple или Facebook сейчас активно пытаются засудить за монополизацию рынка. А объединение какой-то мощной системы во что-то одно и очень общее – это и есть монополизация, только на следующем уровне знания о пользователях. Сейчас же проходят массовые суды на тему того, чтобы поделить Google на части, запретить Google Chrome пользоваться информацией о поиске людей в интернете. Разделить эти бизнесы так, чтобы они не могли пользоваться общей информацией внутри Google. Я думаю, что здесь какая-то такая же штука нам грозит, только в большем масштабе. То есть какие-то судебные истории, законодательные регуляции. Системы будут существовать, но в таком виде тебе показывать рекламу будет нельзя.

А.Г: Остается надеяться на то, что корпорации не смогут договориться. Слабое утешение, честно признаться, на пороге вхождения в замечательный новый мир. Мне все эти разговоры про исчезновение приватности напоминают то, что было при появлении и распространении технологии рентгена, в начале прошлого века. Когда только появились первые рентген-аппараты и люди как-то начали про них узнавать, появилось множество тревожных мнений, буквально созвучных с теми, что мы озвучиваем сегодня. Якобы у полицейских будут портативные рентген-аппараты и они будут ходить просвечивать насквозь дома и видеть, что там происходит. Даже у Замятина в «Мы» были стеклянные дома с прозрачными стенами. Может, мы зря переживаем и мы просто на новом витке все исчезающей, но никак не исчезнувшей приватности? Может, мы что-то придумаем? Появятся какие-нибудь шляпы, которые тебя скрывают.

А.П: Они уже есть. Есть специальные очки или способы нанести макияж так, чтобы тебя не распознавали системы видеонаблюдения. Я думаю, что все будет нормально и это просто новый виток, с которым мы справимся. Эта регуляция придет со стороны государств. Они обеспокоены тем, что большие корпорации монополизируют рынок и по сути становятся настолько же сильными, как и государства. Государства пытаются с этим делом побороться. На самом деле, я думаю, что совсем недалек тот виток, когда эти переживания нам будут казаться чем-то прошлым, когда мы начнем внедрять себе какие-нибудь чипы в мозг, вот тогда такие же разговоры на новый уровень выйдут.

А.Г: Мы уже будем говорить про приватность мыслей и внутреннего мира.

А.П: Да, да. Тут Оруэлл будет еще больше вспоминаться.

О системе социального мониторинга

А.Г: Давай вернемся к Китаю и поговорим про связанную со всеобщим наблюдением систему социального мониторинга, социальных очков. Все ваши поступки становятся видимыми и можно назначить каждому действию значение с плюсом или минусом в зависимости от того, считаем ли мы это действие хорошим или плохим, вычислить ваш социальный рейтинг и на основании этого рейтинга давать вам скидки в магазинах или наоборот. Как тебе эта идея? Потому что в Китае она, судя по всему, надолго.

А.П: Я не думаю, что она будет внедрена в странах с западной культурой. Меня поразило то, что понятие личных границ, которое есть у меня, оно у китайцев совершенно другое. Насколько близко друг к другу можно подходить или как громко можно говорить, когда кто-то рядом стоит. Как можно себя вести. Эти вещи просто совершенно по-другому работают в их культуре. Понятие личных границ там в значительно меньшей степени существует. Я не думаю, что такую систему можно будет внедрить в странах, где есть понятие личного пространства, в которое нельзя проникать. По крайней мере, я ожидаю сильный отпор со стороны общества.

А.Г: То есть ты видишь в этом такое противостояние индивидуализма и коллективизма?

А.П: Да, сто процентов. Западное общество не настолько коллективное, чтобы можно было внедрить что-то такое. Вот в Китае меня поразило – у них другая культура в плане взаимодействия друг с другом, взаимодействия внутри компаний, университетов, компаний и государства. Это работает по-другому. Поэтому я думаю, что это воспринимается по-другому жителями.

А.Г: У меня другая проблема с социальными рейтингами. Мне кажется, она невозможна в западном обществе не потому, что мы все такие индивидуалисты. Я, кстати, в это не верю. Мне кажется, что у нас, в России, по крайней мере формируется некоторое коллективное самосознание и ощущение, что мы в обществе живем, а не каждый сам по себе. В западных странах, мне кажется, оно еще более развито. Есть некоторое ощущение, что мы в одной лодке находимся, а не плывем порознь. Основная претензия для меня заключается в том, что то, что хорошо и что плохо, кем-то решено и как-то запрограммировано и в этой системе заложено изначально. А если оно заложено изначально, оно становится ригидным. Кто те люди, которые программируют систему, они ведь как-то сразу хозяевами мира становятся, ведь они решают, что хорошо, а что плохо. И получается, что мы, как общество, будем лишены возможности саморефлексии. А может быть, то, что мы считали плохо вчера, уже хорошо, или наоборот? Далеко за примером ходить не надо. Столетие с небольшим назад, даже меньше, люди считали, что рабство – это нормально. А сейчас нам кажется, что это ну, несколько устаревшее мнение. А как быть, если это все закреплено на уровне IT системы, которая назначает социальный рейтинг на основании тех представлений о хорошем и плохом, которые были когда-то в прошлом и не факт, что уже актуальны сейчас. Сложно представить, как это может работать. Мне вспоминается сразу сериал The Good Place, «Хорошее место», не знаю, как его на русский перевели. Ты его смотрела?

А.П: Слышала, но не смотрела.

А.Г: Очень хороший сериал, он как раз про этику в современном обществе. Ничего спойлерить не буду, но там есть система, которая определяет, кто попадает в рай, а кто в ад. Есть балловая система, по сути, то же самое, что в Китае сейчас. Определенные действия засчитываются с положительным знаком, другие – с отрицательным. Не зная системы, жить и принимать рациональные решения и жить хорошую жизнь с точки зрения системы просто невозможно. Это очень хорошая критика наших представлений об этике. Если мы лишены возможности принять осознанный выбор, то как вообще мы можем жить праведную жизнь? Все это настолько странно, произвольно, не известно, на каких правилах основано. Да еще и подвержено изменениям или ошибкам. Никто же не застрахован от того, что программист перепутает одну переменную с другой и вот, пожалуйста.

А.П: Да-да, система ошибется и ты попадешь в те самые 0,04% процента людей, которых не различают друг с другом. Я согласна. Плюс непрозрачность этих правил – это огромная проблема. Их, с одной стороны, нельзя сделать прозрачными, потому что тогда всем людям будут доступны данные о всех остальных. А с другой стороны, если это непрозрачная система, то как и кем принимаются решения – тоже совершенно непонятно. В общем, я не вижу здесь плюсов, но вижу много-много минусов.

А.Г: Ты, кстати, классную штуку сказала. А что, если эта система будет доступна абсолютно всем? Всепроникающее наблюдение и всепроникающее знание о другом. Вот просто представь себе мир, в котором у каждого есть супер навороченные Google очки или линзы, или чип в мозгу с системой распознавания лиц. Мы идем в толпе и про всех знаем абсолютно все. Что делал человек вчера, что позавчера, с кем он дружит, где он был, вот его фотография, вот, где живет его мама. Насколько странный это мир! Мне сложно представить человеческое взаимодействие в нем. Например, ты встречаешься с кассиром в пятерочке и понимаешь, как он здесь оказался, вся его жизнь у тебя перед глазами. И у него твоя тоже.

А.П: Прошлая стрижка была лучше! Да, очень странный мир.

А.Г: Представить в нем нормальное человеческое взаимодействие совершенно невозможно. Так что не хочется в нем оказаться.

А.П: Это муравейник скорее. Это должно быть общество, в котором вообще нет эгоизма. Вообще нет никакого желания эксплуатировать эту информацию, а только желание, например, всем вместе лететь на Марс. Но люди не так устроены, поэтому я думаю, что это невозможно.

А.Г: Есть ощущение, что найдутся эксплуататоры. Нет уверенности, что все будут такими сознательными и не будут пользоваться себе во благо и другим во вред. Хотел бы тогда пожелать твоей компании и всем компаниям, которые занимаются разработкой таких систем, больших успехов. Но важно, чтобы был диалог с обществом, чтобы мы все были готовы к тому, что происходит, а не внезапно проснулись в 1984-м.